神仙打架!AMD发布“最强算力”,性能超越英伟达H100 HGX【附AI芯片行业市场分析】

图源:摄图网

12月7日,当地时间周三,AMD举行“Advancing AI”发布会,发布诸如Instinct MI300X、MI300A等。

其中,Instinct MI300X加速器由8个MI300X组成,能够提供高达1.5TB的HBM3内存容量。与Instinct MI250X相比,MI300X系统计算单元多出了接近40%,还有1.5倍的内存容量,以及1.7倍的峰值理论内存带宽。同时新系统也支持FP8、稀疏性等更多的数学格式。

据AMD表示,Instinct MI300A是世界首款专为HPC和AI设计的APU,使用的HBM3内存规格为128GB。与Instinct MI250X相比,MI300A的性能功耗比能接近翻番。苏姿丰宣布,Instinct MI300X加速器已经从今天开始发货,与此同时,Instinct MI300A加速器也已经进入了量产阶段。

AMD表示,与英伟达H100 HGX相比,Instinct MI300X加速器在运行大语言模型推理时的吞吐量和时延表现要明显高出一截,在各项AI和HPC项目中也明显要高出一头。

不过,英伟达在11月中旬发布了新一代人工智能(AI)芯片H200。这是H100芯片的升级版,基于英伟达的“Hopper”架构,首次采用HBM3e内存。英伟达表示,H200使用HBM3e内存能够以每秒4.8TB的速度提供141GB的容量,相比于A100,其容量几乎翻了一倍,带宽提高了2.4倍。据悉,在执行推理或生成问题答案时,H200的性能比H100提升了60%至90%。

总的来说,AMD和英伟达在人工智能领域的竞争激烈异常。两家公司都不断推出新的加速器和处理器,不断提升性能和内存容量,力求取得领先地位。AMD的Instinct MI300X和MI300A加速器在性能和内存容量上有着明显的优势,而英伟达的H200芯片也在容量和带宽方面取得了巨大的提升。可以预见,AMD和英伟达在AI领域的竞争将会越来越激烈,也将为用户带来更多更快更强大的人工智能解决方案。

资本持续关注,AI芯片投融资市场火热

我国人工智能芯片行业起步晚,但发展迅速;2016年,我国人工智能芯片行业投融资事件只有2起,随着大数据、云计算、物联网、自动驾驶领域的飞速发展,市场需求逐年扩大,我国人工智能行业投融资市场也逐渐活跃,到2021年达到近年来的顶峰,融资金额176.46亿元,投融资事件达到44起;2021年后我国人工智能芯片行业虽然稍有遇冷,2022年我国人工智能芯片行业发生融资事件22起,较上年下降50%;融资金额为112.48亿元,较上年下降36%,但整体仍处于高位,AI芯片仍然是内外资本持续关注的热点。

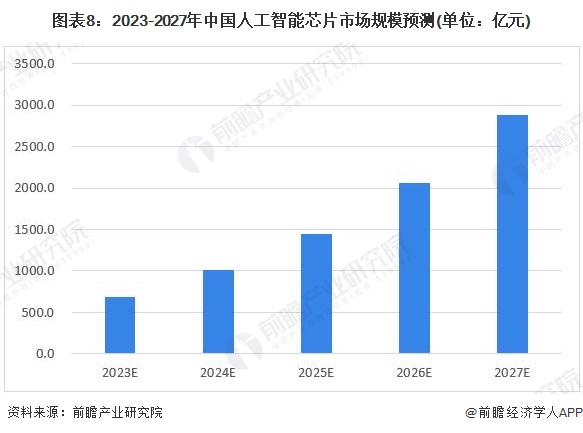

中国人工智能(AI)芯片市场规模将持续上涨

人工智能芯片产业是信息产业的核心,是引领新一轮科技革命和产业变革的关键力量。近年来,随着大数据、云计算、物联网、自动驾驶领域的飞速发展,市场需求逐年扩大。前瞻产业研究院预计2023-2027年,中国人工智能芯片市场规模将持续上涨,到2024年,中国人工智能芯片市场规模将突破1000亿元;到2027年,中国人工智能芯片市场规模达到2881.9亿元。

万联证券指出,随着国内大模型及更多AI应用落地,AI芯片预计将保持较高景气度。产品方面,GPU凭借并行计算具备强大算力,占据AI芯片大部分市场。未来,随着先进封装及Chiplet技术的发展和应用,国产AI芯片有望逐步突破并实现进口替代,国内人工智能算力供给的国产化率有望持续提升。

前瞻经济学人APP资讯组

更多本行业研究分析详见前瞻产业研究院《中国人工智能芯片(AI芯片)行业发展前景预测与投资战略规划分析报告》

同时前瞻产业研究院还提供产业大数据、产业研究报告、产业规划、园区规划、产业招商、产业图谱、智慧招商系统、行业地位证明、IPO咨询/募投可研、专精特新小巨人申报、十五五规划等解决方案。如需转载引用本篇文章内容,请注明资料来源(前瞻产业研究院)。

更多深度行业分析尽在【前瞻经济学人APP】,还可以与500+经济学家/资深行业研究员交流互动。

广告、内容合作请点这里:寻求合作

咨询·服务