Seedance 2.0火出圈,意味着AGI又近了一步

作者|苗正 来源|字母AI(ID:faceaibang)

“目前暂不支持输入真人素材作为主体参考。我们深知创意的边界是尊重。”

这是打开即梦web平台时用户看到的提示。就在前一天,Seedance 2.0因真人肖像生成能力引发争议,字节跳动紧急下线了真人人脸素材参考功能。

引发禁令的是影视飓风Tim在凌晨发布的一条视频,他说Seedance 2.0是“改变视频行业的 AI”,可他的语气并不是赞叹,而是一种警醒。

原因是他发现,仅上传自己的人脸照片,模型就能自动生成与他本人高度相似的声音,甚至精准匹配语气特质。真实地让人感到害怕。

但在功能下线之前,Seedance 2.0已经完成了一次现象级的出圈。《黑神话·悟空》制作人冯骥在微博上称其为“当前地表最强的视频生成模型”,并警告“逼真的视频将变得毫无门槛”。

印象中在此之前,冯骥给予这么高评价的,也就是DeepSeek。

自字节跳动开启 Seedance 2.0开始灰度测试,不到48小时,X、抖音等社交平台充满了铺天盖地各种基于该模型的 AI 视频。

《火影忍者》、《咒术回战》、《奥特曼》……基本上你能想到的作品全都有。

海外反应同样炸裂。X 平台上,一位学习7年数字电影制作的用户发帖:“这是唯一让我感到害怕的模型,90% 我学到的技能它都能实现。”

AIGC圈大佬,Sensive和KidsHackClub的联合创始人莱纳斯·埃肯斯塔姆(Linus Ekenstam)直接回复这条X说:“它会让互联网崩溃,百分之百。”Hacker News上,更是有人直言“这是2026年最好的视频模型,超越Sora 2”。

超越Sora尚在其次,更重要的是,物理世界的准确建模被视为通用AGI的关键能力之一,而Seedance 2.0让业内人士看到了实现这一点的可能性。

2月9日,A 股的传媒、短剧、AI 应用板块也随着 Seedance 2.0 的爆火而集体大涨。上海电影、完美世界等公司单日涨幅达 10%,分析师预期该模型将大幅降低制作成本、加速内容生产周期。

爆火背后,问题同样尖锐。

Sora 2可以说是前车之鉴。刚推出时,Sora 2好评如潮,然而仅仅过去两个月,留存率就无限接近于零。除此之外,版权风险、数字授权等问题,也已经在Sora 2上面暴露过一次了。

字节会带着Seedance 2.0,找到另一条出路吗?

01

什么是Seedance 2.0

在了解Seedance 2.0火爆之前,不妨让我们先来认识一下它。

Seedance 2.0支持文本、图片(最多 9 张)、视频(最多 3 段,总长≤15 秒)、音频(最多 3 段,总长≤15 秒)同时输入,混合上限 12 个文件。

用户可用图片定义构图和角色、视频指定动作和镜头运动、音频驱动节奏。

相比之下,Sora 2的Cameo功能仅支持单张照片植入,Veo 3和Kling 2.6主要依赖文本加单图输入。

这种多模态能力不是简单的素材叠加。字节引入了@提及系统,这样就能明确控制每个资源。

在提示词中,用户可以写“ @Image1作为第一帧,参考@Video1的运镜,使用@Audio1作为背景音乐节奏”。

其最大的好处就是,改变了以往“扔一堆素材给AI,然后碰运气”的创作模式。

模型采用“Seedance V2运动合成”技术,在重力、动量、碰撞、流体等物理现象的模拟上有明显改进。

实测显示,布料飘动、液体飞溅、肢体运动的轨迹更接近真实物理规律,减少了“漂浮感”和物体穿模等常见伪影。

Seedance 2.0还有一个很重要的能力就是精准首尾帧。

用户上传起始帧与结束帧图像后,模型智能推演中间动态过程,确保转场自然、节奏稳定。这对广告定格动画、剧情衔接等强控制需求场景特别有用。

分镜驱动视频生成支持按分镜脚本逐镜生成,跨镜头维持角色外观、光影逻辑与美术风格一致性。有用户用Lovart的Skill生成分镜故事板,直接复制到Seedance 2.0中,生成的视频比用ComfyUI手工调参做的还细致。

这说明模型不仅理解单个画面,还理解镜头之间的叙事逻辑。

Seedance 2.0的编辑能力也得到了增强,支持对已有视频进行角色更替、删减、增加。用户可以直接在生成结果中编辑局部画面,而不是推倒重来。这大幅提升了成片率,也让创作流程更接近传统视频编辑的体验。

从单一提示词可生成包含多个镜头切换的完整片段。

模型能自动规划分镜、执行运镜(如渐进、环绕、跟随)、添加剪辑效果(如慢动作、镜头抖动)。多镜头间保持角色面部特征、服装细节、场景光照、叙事基调的一致性,过渡较为自然。

最后就是视听联合生成方面,音频与视觉在创作过程中相互影响。

支持8种以上语言的音素级口型同步,环境音效与视觉事件实时对应。脚步声匹配角色移动,玻璃破碎伴随清脆音效。上传音频可驱动视频生成,BGM节拍对应镜头切换。

通过火山引擎RayFlow优化,生成速度比1.0版本提升约30%。10秒1080p带音频视频约需2-5分钟。Pro版本支持原生2K分辨率,视频可延长至2分钟,相比Sora 2的15秒上限和Kling 2.6的10秒限制有明显优势。

角色一致性机制引入增强版“身份持久性”注意力机制,在不同镜头、角度、光照条件下保持角色特征稳定。面部轮廓、发型、服装纹理等细节在镜头切换时漂移较少。

二

出圈竟是因为AGI?

在X、抖音等社交媒体上,Seedance 2.0最受关注的内容集中在热门IP角色的格斗与动作视频:真人版七龙珠战斗、奥特曼对决、运动广告。

这类内容的点赞数普遍在数十万级别。

从视频的观感来讲,动作场景对物理模拟精度要求极高,任何失真都会破坏可信度。

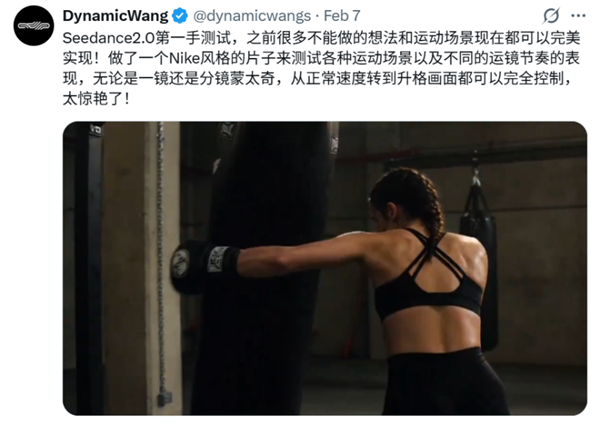

拳击手出拳时的重心转移、击中目标的形变反馈、被击者后退距离需符合力学规律。AIGC艺术家DynamicWang用Seedance 2.0制作的Nike风广告中,四位女性的肌肉线条、动作幅度与其运动项目(体操、拳击、跑步、游泳)高度匹配。

体操翻转、武术连续踢腿、跑酷墙面反弹等动作链条中,任何一帧的速度、角度、加速度偏差都会产生“机械感”。Seedance 2.0通过时序一致性建模,使动作流畅度接近实拍效果。

格斗时的扬尘、武器破风声、衣袂翻飞的褶皱等二次物理效应增强了场景真实感。

物理世界的准确建模被视为通用AGI的关键能力之一。

“物体如何运动”“力如何传递”“因果如何发生”,虽然这些事情对我们早已司空见惯了,但是对于AI这还是新鲜事。

当AI模型能准确预测拳头击中目标后的形变、水花溅起的轨迹、布料随风飘动的形态,意味着它不再是简单的“像素生成器”,而是建立了对真实世界运作机制的内部表征。

杨立昆曾多次强调,AGI必须具备对物理世界的常识性理解。

Seedance 2.0在物理模拟上的提升,本质上是其世界模型能力的增强,模型开始理解物体之间的关系、动作的因果链条、环境对物体的约束。

传统生成模型依赖“数据中出现过什么,就生成什么”的统计规律,然而真实世界遵循因果逻辑,推倒多米诺骨牌,后续骨牌必然倒下;拳头击中脸部,头部必然后仰。

Seedance 2.0能够生成符合物理规律的格斗视频,说明模型内部已经形成了某种因果推理能力。

它不是记住了“拳击的样子”,而是理解了“力的作用必然产生反作用”这一底层逻辑。这种能力是从“模式识别”向“概念推理”的跨越。

传统AI是停留在统计层面的拟合,只有当AI理解了物理世界,才能真正与现实交互。

这也是为什么之前各大厂一直强调多模态。

因为咱们人类的大脑理解物理世界,本质上就是多模态。我们通过视觉看到物体运动,通过听觉感知碰撞声响,通过触觉理解材质硬度,这些感官信息在大脑中融合形成统一的世界理解。

前文提到的Seedance 2.0视听联合生成架构,在某种程度上就是模拟了这种多模态融合机制。

当模型能够理解“重物落地应该发出低沉声音”“玻璃破碎应该伴随清脆音效”时,它已经在建立跨模态的因果关联。这种能力远超单纯的文本生成或图像生成,已经预示着模型正朝着AGI靠拢了。

还有一点,当前AI研究的共识是,AGI最终需要体现在具身智能上。

原因很简单,一个能够在物理世界中行动的智能体,无论是机器人还是自动驾驶,都要求AI准确预测物理世界的动态变化。

Seedance 2.0虽然是视频生成模型,但它对物理规律的理解能力(重力、动量、碰撞、流体力学)与具身智能所需的能力高度重合。

可以说,视频生成是具身智能的“沙盒”。

模型在虚拟世界中学会了物理规律,未来可以迁移到真实世界的机器人控制中。而基于Seedance 2.0的那些格斗视频,刚好集中体现了模型对力学、运动学、时序因果的综合理解,这些都是具身智能的核心能力。

GPT、Claude等大语言模型虽然强大,但它们对物理世界的理解是间接的、基于文本描述的。它们可以告诉你“苹果会掉下来”,但无法真正“看到”重力如何作用。

Seedance 2.0的突破在于,它通过视频生成这一任务,被迫学习物理世界的直接表征。

这使得它在通往AGI的路径上比纯语言或静态图像模型走得更远,所以它的运行逻辑更接近人类“看到-理解-预测”的认知闭环。

如果说语言模型是AGI的“左脑”(逻辑与符号),那么物理世界模型就是AGI的“右脑”(空间与直觉)。

Sora 2在静态场景和慢节奏叙事上表现较好,但在快速动作场景存在明显短板。篮球弹跳轨迹、水流形态、布料飘动呈现“梦幻感”而非“真实感”,慢镜头下尤为明显。

角色快速位移(冲刺、跳跃、挥拳)时容易产生运动模糊过度或肢体变形,源于扩散模型处理时序剧烈变化的局限。

Sora 2 要生成单镜头,用户拼接多个动作片段时,角色动作衔接、速度一致性难以保证。

格斗视频需要“出招-闪避-反击”的多回合结构,这是Sora 2的弱项。社交媒体上Sora 2生成的同类内容常因“动作僵硬”“物理违和”被用户批评。

字节在短视频领域的数据积累可能是优势来源。

抖音每日处理数十亿条视频,这些数据帮助模型理解“什么样的运动吸引眼球”“哪种节奏让人持续观看”。模型训练可能使用了大量真实武术、体育、舞蹈视频作监督信号。

三

字节能从Sora 2上吸取教训吗?

OpenAI将 Sora 2 定位为“AI 版抖音”。首日10万安装(邀请制 iOS)、4天登顶美国App Store总榜、5天破100万下载(快于 ChatGPT)。

但Appfigures数据显示,Sora 2在60天内的下载量出现断崖式下滑。12月环比下降32%,1月环比大幅下降45%,降至约120万次。

截至发稿,Sora 2目前已跌出美国App Store免费应用总榜前100名。

Sora 2最大的战略失误是试图复制抖音那套社区文化。

AI生成内容天然缺乏真实人际关系,这是社交网络的核心之一。用户在抖音上刷到的是真实的人、真实的生活片段、真实的情感连接。而Sora 2生成的视频,无论多么精美,本质上都是算法的产物,缺乏社交网络赖以生存的人际纽带。

Seedance 2.0目前的做法更务实,嵌入剪映、即梦等成熟创作工具,作为“功能模块”而非“独立 App”。

将自己定位为创作者工具箱的一部分。用户不是来“刷AI视频”,而是来“用AI做视频”。这个定位差异,决定了产品的生命周期。

Sora 2在版权上的摇摆暴露了西方监管环境的困境。

上线初期,因缺乏严格管控,用户曾可生成海绵宝宝、皮卡丘等知名IP角色的视频,这虽在一定程度上有助于早期推广,但引发了版权方的强烈反对。

面对压力,OpenAI将版权使用规则从“默认可选”改为“需明确授权”,也正是因为这种版权内容的变更,导致Sora 2失去了最初病毒式传播的动力源泉。

目前来看,Seedance 2.0另一大爆火的原因,是创作者利用AI生成了奥特曼、七龙珠等大量知名角色,但同样存在版权风险,比如下图中就是赵本山和詹姆斯。

字节因真人素材参考能力引发争议后,已紧急下线该功能。这说明字节在版权问题上采取了更谨慎的态度,试图在技术能力与合规风险之间找到平衡点。

但最重要的是,当任何人都能在几分钟内生成一段精美视频,内容本身就失去了稀缺性。用户真正需要的不是“更多视频”,而是“更有意义的表达”。

技术再强,如果不能回答“用户为什么需要这个”的问题,最终都会沦为玩具。

AI生成的视频虽然精美,但往往缺乏核心的情感内核与持续的叙事价值。许多用户在社交平台上反馈,在最初的新鲜感褪去后,Sora 2生成的内容逐渐趋同且无趣。

Seedance 2.0若想长期存活,需要回答一个问题:在AI让视频生成成本趋近于零的时代,你为用户创造的核心价值是什么?是节省时间?是实现创意?还是建立身份认同?

从目前的产品策略来看,字节选择了“工具”而非“平台”的路线。

但工具路线也有自己的挑战。当可灵、Sora、Veo都在提供类似能力时,用户凭什么选择 Seedance 2.0?答案可能不在技术本身,而在生态整合的深度。

字节拥有抖音、剪映、即梦的完整创作生态,Seedance 2.0如果能与这些产品深度打通,形成从灵感到发布的闭环,就能建立起其他竞争对手难以复制的护城河。

不过归根结底,版权问题是永远不会消失的,技术能力的边界也会不断被竞争对手追平。真正决定Seedance 2.0命运的,是字节能否在爆火的窗口期内,将流量转化为用户习惯,将技术优势转化为生态壁垒。

答案可能决定了它是成为字节的下一个抖音,还是下一个 Sora 2。

编者按:本文转载自微信公众号:字母AI(ID:faceaibang),作者:苗正

广告、内容合作请点这里:寻求合作

咨询·服务